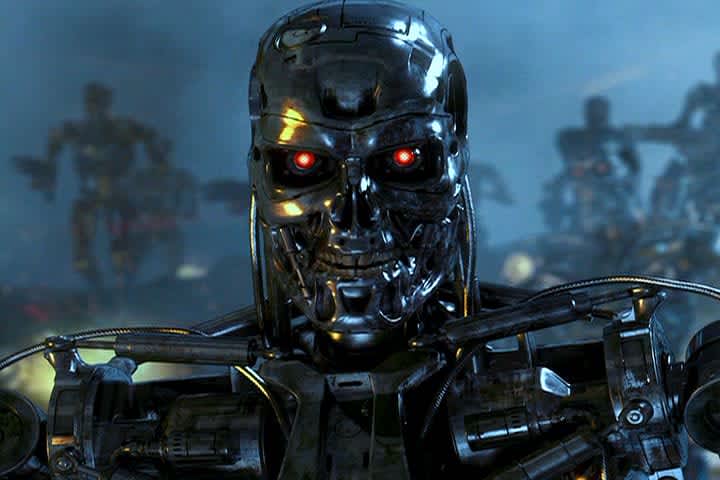

OpenAIは、暴走したAIテクノロジーによって引き起こされる人類滅亡の可能性に関して懸念を表明しており、このような危機を回避することを目指すチームを結成しました。

OpenAIによれば、AIは超知能に進化する能力を持っており、これは人類が達成した最も重大な技術的飛躍であり、重要な世界的ジレンマの解決に貢献する可能性があります。

しかし、OpenAIのIlya Sutskever氏とJan Leike氏は、我々人類は自分たちの認知能力を超える技術と対峙するための適切な能力を備えていないと警告しています。

超知能AIの危険性

OpenAIチームは、超知能AIについての差し迫った危険性を認識しており、現時点ではその行動を制御または転換する解決策が欠けていることを認めています。AIを調整するための既存の手法(例:人間のフィードバックによる強化学習)は、人間による監視に依存しています。しかし、AIシステムが知能で人間を超越すると、この監視は信頼性を失います。

OpenAIの共同創設者で主任科学者であるSutskever氏と、OpenAIの整合部門の責任者であるLeike氏は、超知能によって引き起こされる技術的障壁を乗り越えるための研究者とエンジニアのグループを設立しています。彼らは、チームがこの目標を達成するために4年間という期限を設定しました。

人類滅亡の可能性は憂慮すべきものですが、OpenAIのリーダーたちは解決策を見つけることに対して楽観的な見方を持っています。彼らは、集中的かつ協調した努力によって、この困難を解決できると強く信じています。具体的な進展と実験、現在のAIモデルを用いてこれらの課題を経験的に研究出来る能力が、彼らの楽観主義を加速させています。

Sutskever氏とLeike氏は、自分たちの研究成果を広く普及させることに対する堅い信念を強調しています。OpenAIは、AIによる人類の支配や根絶を防ぐことに関心を持つ研究エンジニア、科学者、マネージャーを積極的に募集しています。さらに、OpenAIは、より多くの開発者がアクセスしやすくなるようにするために、最も能力の高いAIモデルであるGPT-4を広く提供すると発表しました。

この記事は、編集部が日本向けに翻訳・編集したものです。

原文はこちら

The post

OpenAIがAIによるカタストロフィーを防ぐためのタスクフォースを組織

first appeared on

.