by 石井 一志

日本電気株式会社(以下、NEC)は24日、LLM(大規模言語モデル)「cotomi(コトミ)」のラインアップにおいて、学習データやアーキテクチャを刷新した「cotomi Pro」「cotomi Light」を開発したと発表した。

NECは2023年7月に、日本語向けのLLMを自社開発したことを発表していたが、今回は高速性と高性能の両立が顧客企業の課題解決に必須と考え、LLMのラインアップを拡充したという。

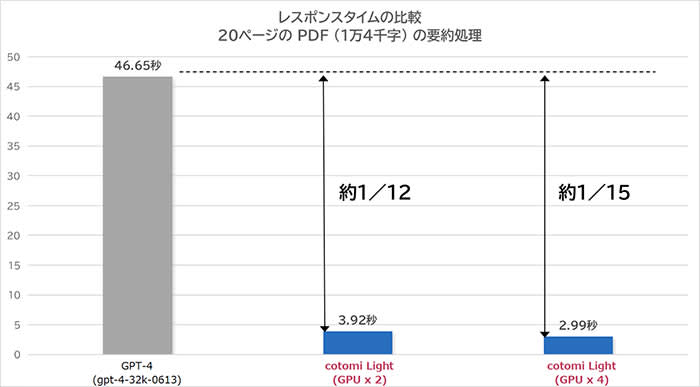

その「cotomi Pro」「cotomi Light」は、グローバルのLLMと同等の高い性能を、十数倍の速度で実現するモデルで、一般的に、LLMの性能を高めるためにはモデルを大規模にする必要があるため動作速度が遅くなってしまうが、学習方式やアーキテクチャを工夫することにより、速度と性能の両立に成功したとのこと。

またNECグループでは、すでに約4万人の社員が生成AIの社内サービスを、約1年、社内業務に活用しており、こうした社内サービスから得られた膨大な対話履歴の解析・活用によって、現実的なユースケースでの性能も大幅に向上したとしている。

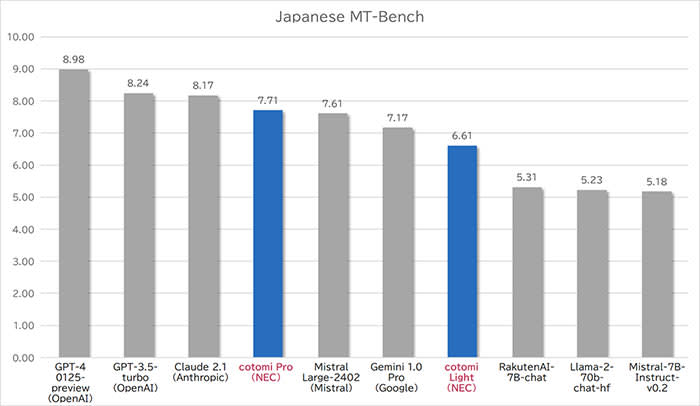

新開発されたラインアップのうち「cotomi Pro」は、GPT-4やClaude 2などのグローバルトップレベルのモデルに比肩する性能を、GPU2枚の現実的なインフラで、GPT-4のおよそ1/8のレスポンスタイムで実現できるという。

また、さらに高速な「cotomi Light」は、GPT-3.5-Turboなどのグローバルモデルと同等水準の性能を持ちながら、GPU1~2枚程度のインフラで大量のリクエストを高速に処理でき、多くの業務で充分な性能を発揮するとした。

具体的には、RAG(Retrieval-Augmented Generation)を用いた社内文書検索システムにおいて、ファインチューニングをしていない状態で、GPT-3.5以上の正答率、ファイチューニング後はGPT-4を超える正答率を、およそ1/15のレスポンスタイムで実現するとのことだ。