Il existe aujourd’hui moult générateurs d’images via IA. Ceux-ci permettent de créer des images très réalistes. Ces outils deviennent de plus en plus puissants, avec toujours davantage de fonctionnalités. Les abonnés ChatGPT Plus ont depuis peu la possibilité de retoucher des zones précises d’une image, comme on le ferait avec Photoshop. Plus besoin de regénérer l’image entière pour changer un élément précis, il suffit d’indiquer à DALL-E la zone de l’image à ajuster, de lui donner un prompt et de laisser l’IA travailler. Très pratique, certes, mais avec certaines limitations tout de même.

Retoucher des images dans ChatGPT

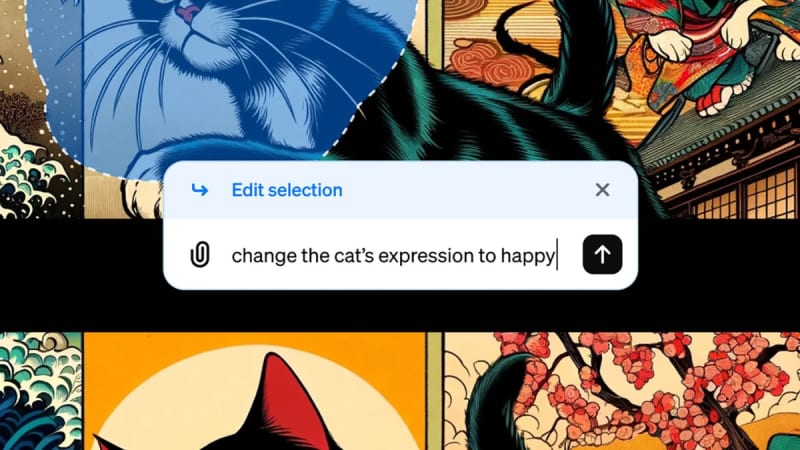

Si vous êtes abonné(e) ChatGPT Plus, vous pouvez faire générer l’image de votre choix en quelques secondes. Pour la retoucher, il suffit de cliquer dessus, un bouton Sélectionner apparaît dans le coin supérieur droit (en forme de crayon avec une ligne). Vous devez alors ajuster la taille de l’outil de sélection pour recouvrir la zone de l’image à faire modifier.

C’est là que les choses deviennent intéressantes. Vous pouvez faire regénérer uniquement cette sélection, là où il fallait jusqu’à présent regénérer toute l’image. Une fois la sélection effectuée, vous saisissez vos nouvelles instructions pour cette section en particulier. Plus vous êtes précis, meilleur sera le résultat. Et votre demande est prise en compte.

D’après mes expérimentations, ChatGPT et DALL-E utilisent la même “magie” que des apps comme la gomme magique de Google, en remplissant intelligemment l’arrière-plan avec les informations existantes d’une scène tout en essayant de ne pas toucher au reste.

Ce n’est pas l’outil de sélection le plus avancé et il y a certaines inconsistances ici et là, mais dans la majorité des cas, les modifications sont assez bien réalisées. Nul doute que OpenAI améliorera l’ensemble avec le temps.

L’IA générative montre ses limites

Si ce nouvel outil d’édition se montre doué pour modifier la couleur et la position d’un objet dans une composition, par exemple, il a bien plus de mal pour réduire la taille d’un géant sur les remparts d’un château. Parfois même, ChatGPT fera même disparaître l’objet qui vous ennuie, et qui l’ennuie aussi.

Cette fonctionnalité reste très jeune, et OpenAI n’affirme en aucun cas que cela puisse remplacer une retouche effectuée par un humain. Ce n’est clairement pas le cas. Les choses s’amélioreront avec le temps, c’est certain, mais l’on voit ici aujourd’hui les limites de ce genre de système.

DALL-E et les modèles du même genre sont très doués pour arranger les pixels et vous donner une bonne approximation d’un château, par exemple, grâce aux très nombreux châteaux qu’ils ont pu voir pendant leurs entraînements, mais l’IA ne sait pas vraiment ce qu’est un château. Elle ne comprend pas la géométrie ni l’espace physique, ce qui explique pourquoi certains châteaux générés sont bigrement difformes. Vous constaterez cela souvent avec les bâtiments, les mobiliers et certains objets.

Ces modèles ne comprennent pas (encore) ce qu’ils vous affichent : c’est pour cela que dans nombre de vidéos générées par OpenAI Sora, les gens disparaissent comme par enchantement, parce que l’IA arrange intelligemment les pixels, sans suivre les personnes. De la même manière, ces IA génératives ont toutes les peines du monde à générer des images de couples d’ethnies différentes, parce que les couples de même ethnie sont bien plus fréquents dans leurs données d’entraînement.

Un autre petit point largement perfectible : l’incapacité de ces générateurs à créer des arrière-plans totalement blancs. Ce sont des outils incroyablement intelligents dans de nombreux aspects, mais ils ne “réfléchissent” pas comme nous, et ne comprennent pas ce qu’ils font comme un artiste humain le ferait. À garder à l’esprit quand vous les utilisez.