by 関根 慎一

インテル株式会社は6日、AI開発者向けイベント「インテルAIサミット」を都内で開催した。

AIハード/ソフトウェア開発者との連携を強化し、強固なエコシステムの確立を目的として開催するイベント。スローガンは「Bringing AI Everywhere」。日本での開催は今回が初めて。前半は基調講演、後半は「AI PC」、「データセンター向け生成AI」、「開発ソフトウェア/エッジAI」の3カテゴリで分科会を実施するという構成となっていた。

本稿では基調講演の模様をお伝えする。

「AI」が1兆ドル規模の半導体市場をけん引する

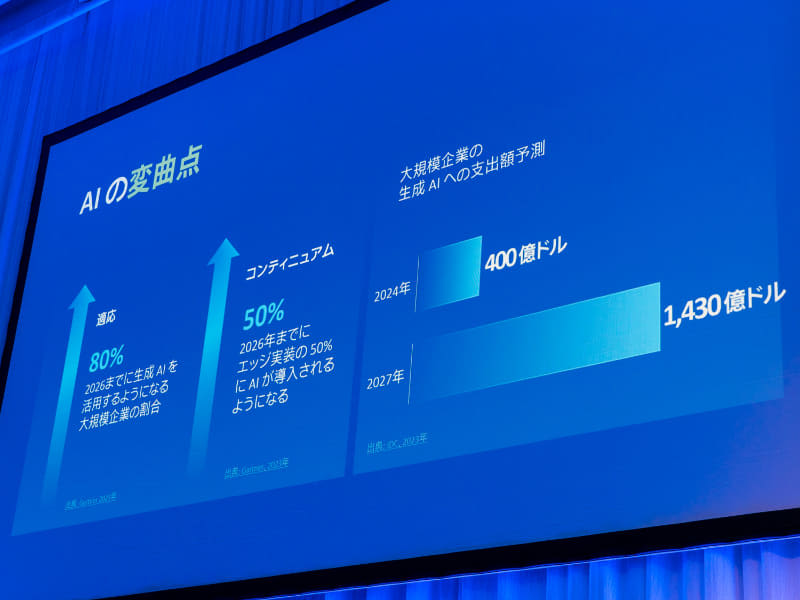

最初の講演は、Intel首席副社長兼セールス・マーケティング・コミュニケーション統括本部長のクリストフ・シェル氏が担当した。「Bringing AI Everywhere、AIの可能性、課題、そしてインテルの戦略」と題して、「AI PC」、「エンタープライズ&エッジ」、「データセンターAI」の3分野におけるインテルの戦略を説明。この中で、大企業による生成AIへの支出額が3年後に3倍を超えるというIDCの調査結果を引用した。

「AIは将来的に、人々が扱うすべてのデバイスや家電、乗り物などに搭載され、結果としてほとんどの企業が、好むと好まざるとにかかわらず、AIを利用せざるを得ない状況になると思います。今、AIほど成長著しいものはありません。半導体の市場は2030年までに1兆ドル規模に成長するでしょう。それをけん引する重要な機動力がAIのワークロードなのです」(シェル氏)。

AI PCに関する取り組みについては、9月頃の発表を予定している「Lunar Lake」のほか、2023年12月に発売した「Core Ultra」を例に挙げ、CPU/GPU/NPUのアーキテクチャをチップのシステム上で成立させる設計のアイデアこそが今後のAI PCの原動力となっていくとの見解を示した。

国内パートナーとしては日本HP代表取締役社長執行役員の岡戸伸樹氏が登壇し、AI PCがユーザーに提供する価値について話した。岡戸氏はこの中で、AI PCの特徴として「速度の速さ」、「コスト」、「セキュリティ」、「パーソナライゼーション」の4点を挙げている。

「AI PCとは、クラウドに依存することなく、ローカル(エッジ)でAI処理が行なえるPCの総称です。ローカルでAI処理を行なうメリットはクラウド経由で行なうよりも速く、安価に済ませられることですが、それ以上に重要なのは、プライバシーが担保された環境で、パーソナライズされた生成AIを活用できることです。これからの"PC"は、これまでの"パーソナル・コンピュータ"から、個人に寄り添って仕事をサポートする"パーソナル・コンパニオン"になっていくのだと思います」(岡戸氏)。

AI PCに関してはこのほか、3年後には日本HPの売上の半分程度をAI PCにしたいとの目標を明らかにした。

エンタープライズ&エッジ分野については、「AIとエッジ」に関する文脈の中で「Tiberエッジプラットフォーム」を紹介。AI処理をエッジで行なう利点として、クラウド上でAI処理を行なう際にかかる費用や通信の遅延が低減できることを挙げた。また金融やヘルスケアなど機密度の高いデータは安全性の面から国内で処理する必要があるなどの制約にも触れ、Tiberが整備しているエッジアプリケーションの導入や管理の効率化、開発サポート体制、セキュリティ対策についても優位性をアピールした。

ここではさくらインターネット株式会社クラウド事業本部AI基盤事業統括の須藤武文氏がビデオメッセージを寄せ、同社のAI分野向け計算資源サービス「高火力コンピューティング」を紹介。近年、マシンラーニング用データの前処理用途においてはマルチモーダル化により容量が増大しているとの課題があるとし、これに対応するため第5世代Xeonを採用したことで、顧客のマシンラーニングモデル開発プロセスの高速化に寄与したと話した。

4日に「6700Eシリーズ」を発表した「Xeon 6」については、Pコア版を「性能重視」、Eコア版を「性能と消費電力のバランス重視」という位置付けを紹介。AI処理を行なう場所(クラウド/エッジ)やモデルの規模によってはコスト効率的にGPUよりもCPUを用いた方が良い場合があり、特に規模の大きなAIワークロードを処理するプロセッサはコストを意識して慎重に検討する必要があるとした。

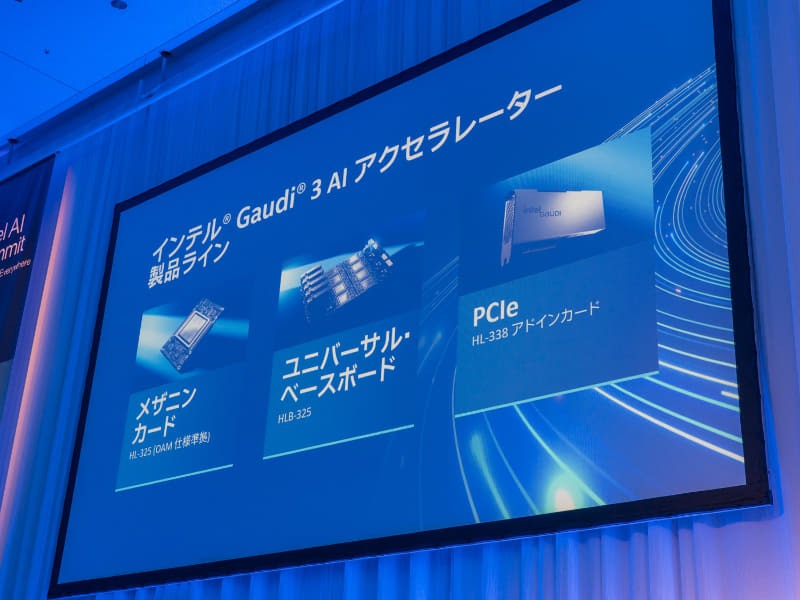

シェル氏はAIアクセラレーター「Gaudi」シリーズを「AIモデルクリエイター向けの製品」と位置づけ、その中で「プログラム可能なASIC」だと表現した。GPUではなくAIアクセラレーターであり、競合にあたるNVIDIAの「H100」などとは異なるシステムだが、独自の環境ではないオープンスタンダードである点を強調している。

4月に発表した「Gaudi 3」では、既存のメザニンカードとベースボードに加えて新たにPCIeアドインカードの提供を開始。柔軟なスケーリングの実現と低消費電力性能をアピールした。

シェル氏はインテルが展開している半導体の受託生産事業についても言及。株式会社Preferred Networks(PFN)執行役員 計算基盤担当バイスプレジデントの土井裕介氏が登壇し、同社とインテルとの取り組みについて述べた。PFNはスーパーコンピュータ「MN-3」に同社独自の「MN-Core」のほかXeonを採用しているほか、Ultra Ethernet Consortium(UEC)にも参加する形でパートナーシップを結んでいる。

「次世代計算機のコアになる部分はASICになると思いますが、そのASICをどう作っていくのかについては、より深く考える必要があります。いかにしてセキュアで効率的な計算機を作っていくのか。人々がAI PCやLLMを活用するなどの形でAIが普及するにあたり、現在の推論はそのコストが非常に高い状態にあります。これを1桁、2桁と下げていくためには、チップの設計という段階から考える必要があると思います」(土井氏)。

土井氏によれば、現在の半導体は微細化にフォーカスしているため、微細化を進めれば進めるほどコストが急速に増加していくことから、結果としてコストダウンに繋がりにくい状況が生まれていることが課題だという。対応策としては裏面電源供給網(BSPDN)やチップレット、3D積層などの技術開発推進を挙げ、ファウンドリ事業の今後への期待を表明している。

「今後、AIは非常に多くの人々の人生を変えていくでしょう。それを恐れる人もいると思います。しかしテクノロジは常に中立であり、そこから何を生み出すのかが重要です。そして良い面と悪い面の両面を見て判断するには"文化"が必要です。AIを競合優位性のために使うのか、それともキャッチアップのために使うのか。皆さんにとって重要なことは何なのか。例えばインテルで最初にAIを活用したのはファブリケーションの分野でした。これからあらゆる企業がAI企業になる中で、皆さんにはAI戦略を考えていただきたいと思います」(シェル氏)。

汎用的な知識を持つAIモデルだけでは十分ではない

インテルの生成AIスピンオフ企業「Articul8」創設者兼CEO、アルン・スブラマニヤン氏による特別講演「企業向け自律型生成AIプラットフォームの必要性」では、生成AIを導入した企業の実情と、利益を生み出せるAIの開発/運用方針について話した。

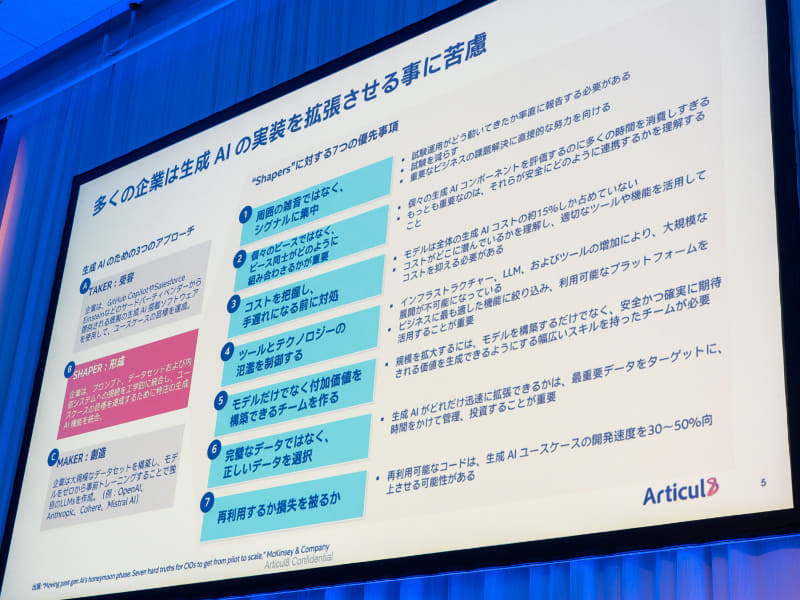

スブラマニヤン氏はまず、AIを導入した企業のうちおよそ90%の企業がプロジェクトで利益を上げられず失敗していることに言及。AIを活用して利益を上げるためには大規模なデータサイエンティストのチームが必要であり、本番環境への実装と維持には高度な技術が必要になるが、多くの企業ではAI人材の獲得に課題があると話した。

「ChatGPTをはじめとした生成AIのサービスは私たちに劇的な変化をもたらすものですが、業務においては役に立つ場合とそうでない場合があります。実際は企業の規模が大きくなればなるほど『役に立たない』ことは許されません。高い信頼性や説明責任が必要になります」(スブラマニヤン氏)。

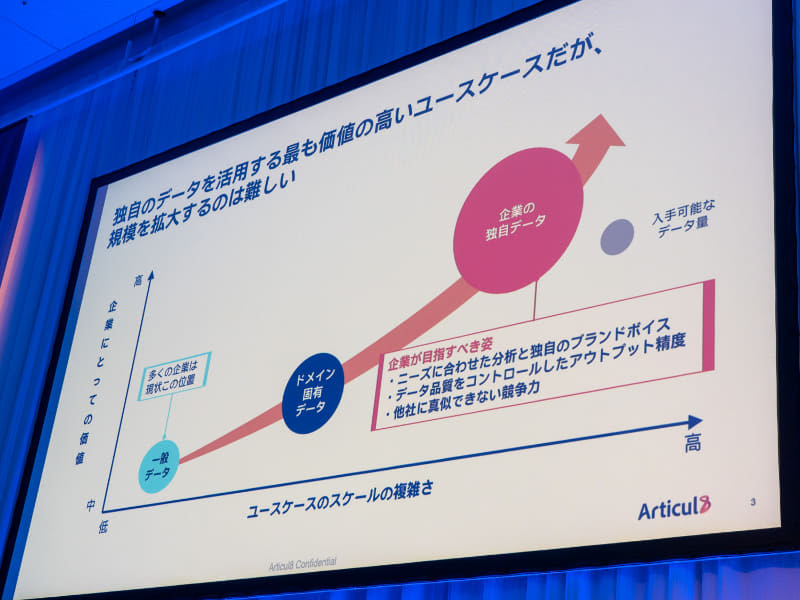

スブラマニヤン氏によれば、モデルがオープンなデータセットによって学習可能な内容は、世界に存在する情報のおよそ5%にすぎないという。残りの95%は組織や企業、個人のファイアーウォールの中にあり、決して露出しない情報だとしている。企業としてAIを活用し、価値を高め、より多くの利益を得るためには、データセットから学習できる内容だけでなく、事業ドメイン固有のデータ、そして自社固有のデータも学習したモデルを構築し、適切に運用する必要があるとした。

「汎用的な知識を持つモデルは必要ですが、それだけでは十分ではありません。いわば氷山の一角であり、水面下にあるものも気にかけなくてはならないでしょう。企業目線で述べるならば、モデルがデータセットによって学べる内容は、いわば『高校生』レベルと言っていいでしょう。どのような業種であれ、業務レベルでAIを活用するのであれば、それは多少なりとも事業ドメインについての知識がある『大学生』レベルであるべきです。

そして次に目指すべきは、自社に入社し、長い時間をかけて専門性を構築した『エキスパート』です。ここで初めて、ニーズに合わせた分析や高精度なアウトプット、ひいては適切な意思決定が可能になります」(スブラマニヤン氏)。

また、実際にはエキスパートレベルのモデルを構築/実装して終わりではなく、コストの計算や効果の検証、運用していく中で生成AIが大きなアドバンテージをもたらしてくれるのはいつなのか、既存のユースケースも引き続き使えるところはどこなのかなどさまざまな条件も組み合わせて考える必要があると話した。

コストに関しては、総所有コスト(TCO)を考慮することも重要だという。これにはハードウェアの購入や稼働にかかる費用とは別に、使い勝手のよいソフトウェアの組み合わせと、開発者やエンドユーザーがどの程度その恩恵を享受できるのかというエコシステムも含まれる。

AI PCはクラウドとエッジをシームレスに繋ぐ

基調講演最後のセッションとなる「インテルが拓くAIの未来 AI Everywhereの加速」では、インテル株式会社代表取締役会長の鈴木国正氏が今回のイベントで打ち出している「AI Everywhere」という概念について説明。現在のAI開発が抱える課題や国内企業におけるAI活用の状況などについて話したほか、Gaudi 3やLunar LakeなどAIに関連する各製品についても言及した。

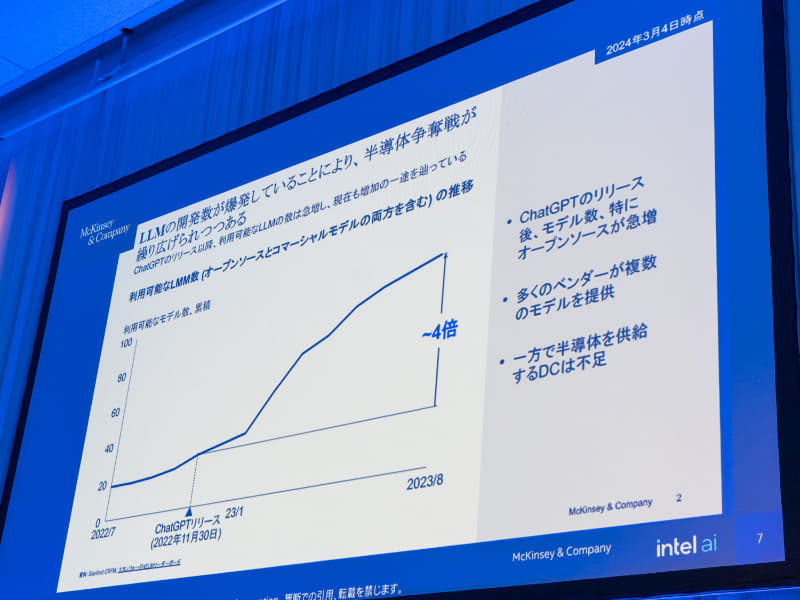

2022年にリリースされたChatGPT以降、国内ではLLMの開発数が急増しており、2023年8月時点でChatGPT前の4倍に達しているという。その一方で半導体を供給するデータセンターは不足し、また支払うコストについても従来から見方を変えて向き合う必要が出てきたと話す。

「それだけいろいろなところがLLMの開発を始めているということで、身に覚えがあるというか、一気に流れがきた感じがしますね。インテルとしても、特にデータセンターは大きなフットプリントがある分野です。技術開発や製品開発、ソフトウェア開発環境をしっかり整えるのがインテルの1つのやり方。業界全体の健全なる発展ができるように貢献したいと思います」(鈴木氏)。

これを踏まえ、今回打ち出している「AI Everywhere」については「すべての開発者やユーザーが安心して安全に運用できるAIテクノロジを提供できること」、「一企業や一アーキテクチャに束縛されることなく、豊富な選択肢の中でより自由に開発できる環境を提供していくこと」と説明した。

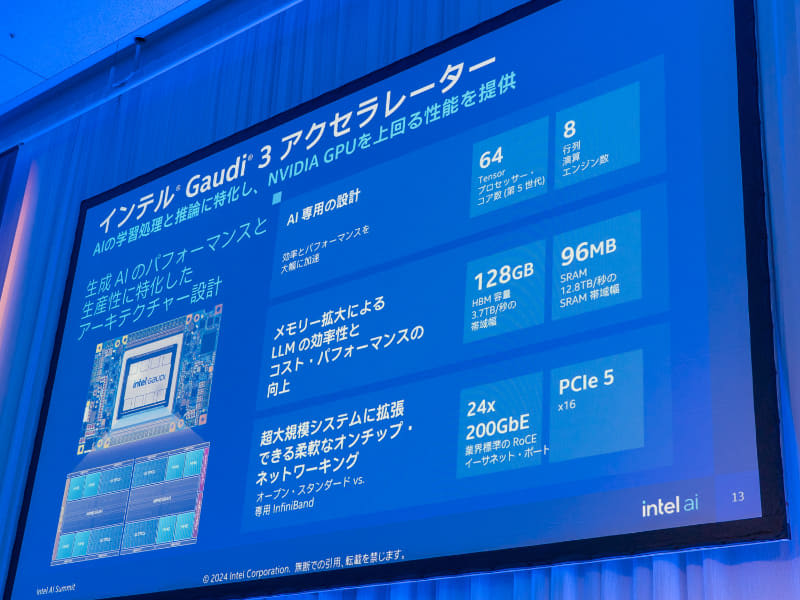

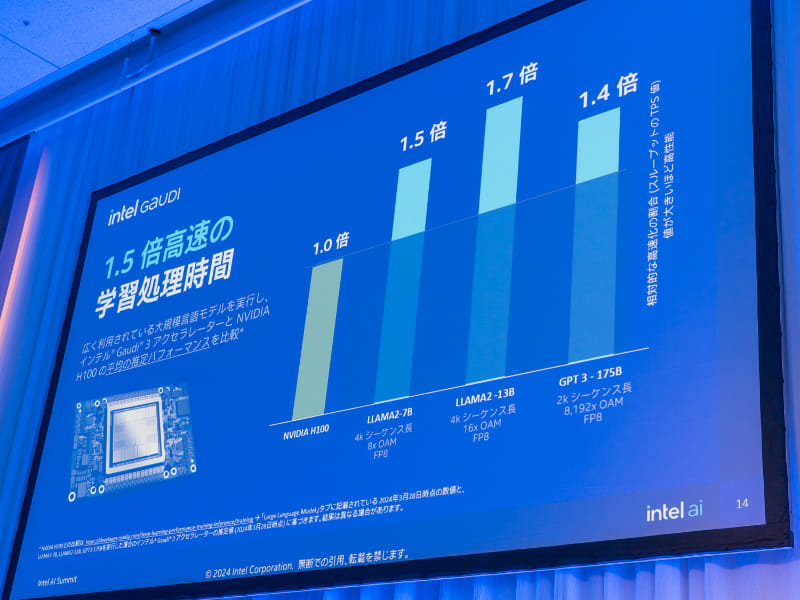

AI Everywhereを実現するプロセスとしては「学習処理」、「ファインチューニング」、「実装」、「推論」の4つを挙げている。このうち学習処理を担うAIアクセラレーターとしてはGaudi 3を紹介。「AIの学習処理と推論に特化し、NVIDIA GPUを上回る性能を提供する」と性能をアピールした。

Gaudi 3は1ダイあたり32コアのプロセッサを2基(計64コア)、行列演算エンジン(MME)は8基搭載。HBMメモリ容量は128GBで、LMの推論や演算のフィッティングに適した性能としている。またネットワークについては200GbEのRoCEポートを備え、超大規模システムに拡張可能なオンチップネットワーキングが実現できるという。

H100(の平均推定パフォーマンス)を基準とした学習処理時間においては、3つのAIモデルで平均1.5倍の性能が出ているとした。

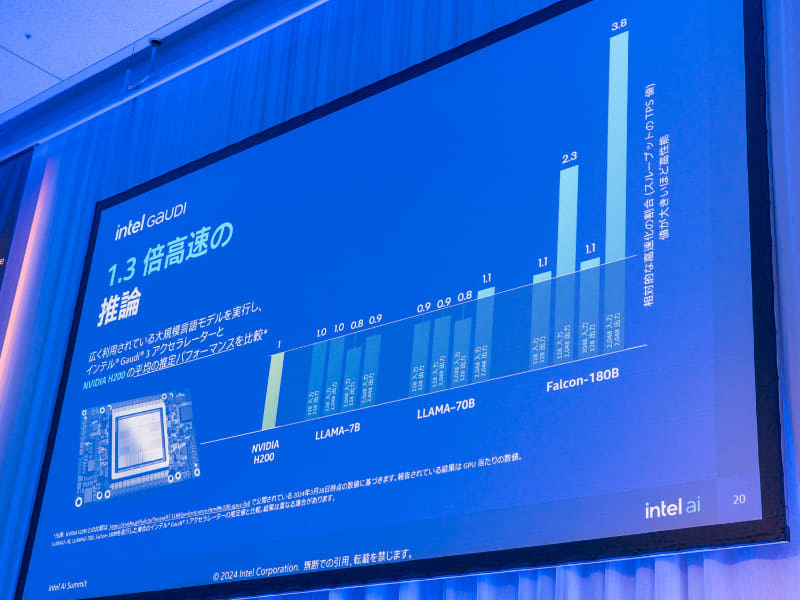

また推論性能についてはH200との比較を行なっており、大きなパラメータ数を持つAIモデル(発表資料ではFalcon-180B)に対して最大3.8倍、そのほかのモデルと併せて平均1.3倍の推論性能を発揮している。

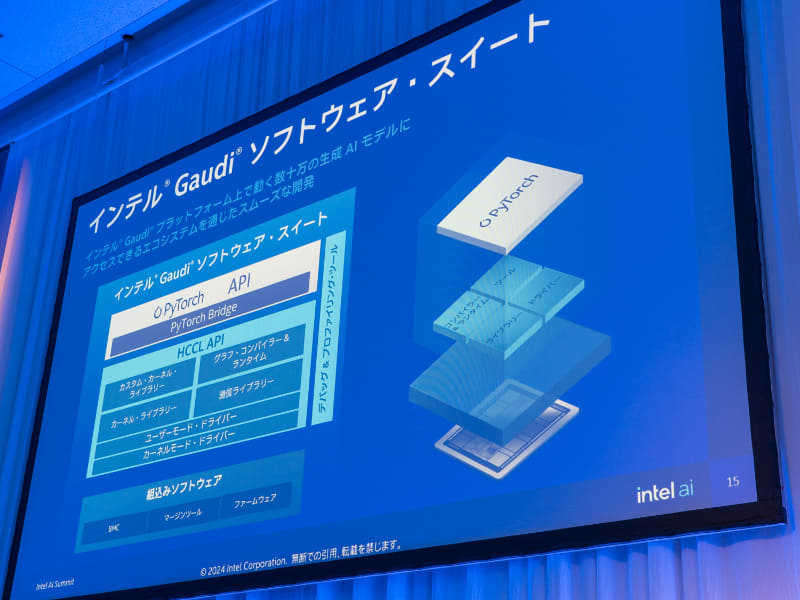

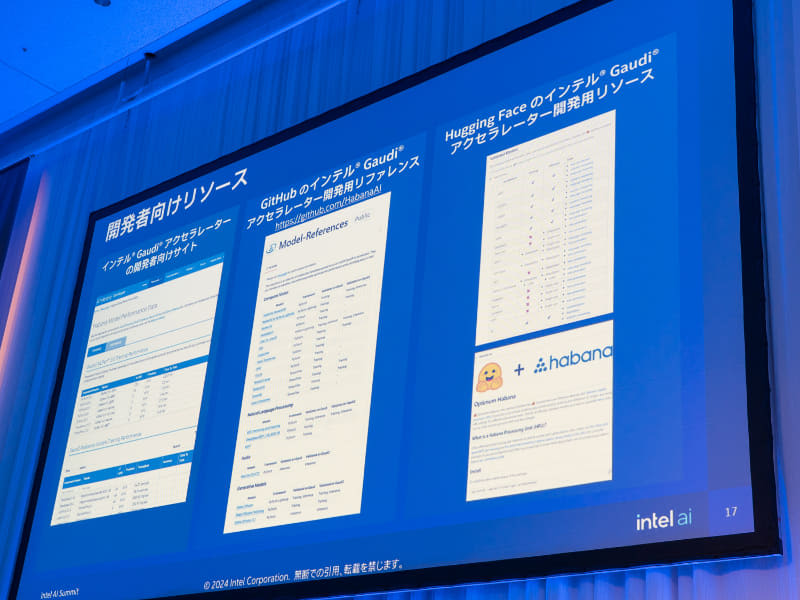

このほかインテルが用意している開発環境についても言及。「Tiberデベロッパー・クラウド」ではGaudi 2からGaudi 3へシームレスにコードを移植できる利便性をアピールし、提供中の「Gaudiソフトウェア・スイート」についてはPyTorchやTensorFlowを用いた抽象度の高いフレームワークをサポートしている点を重要な特徴の1つとして紹介した。

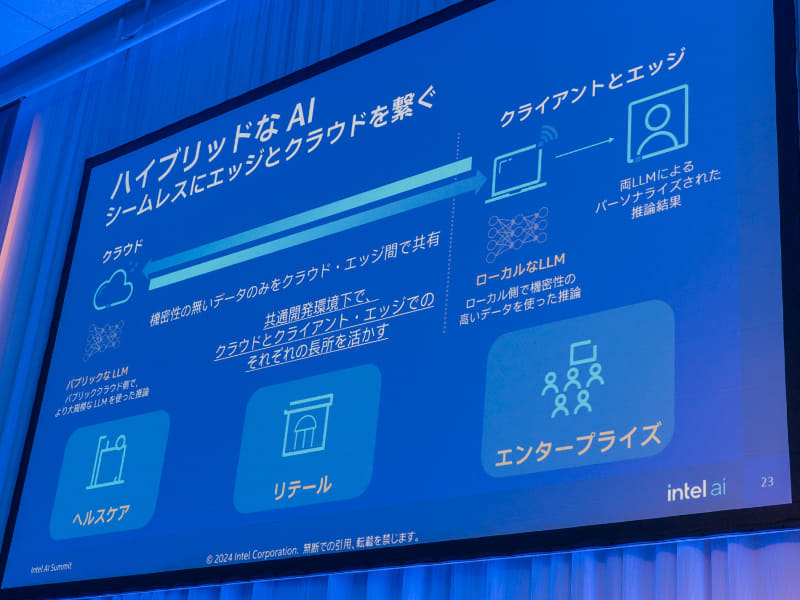

AI PCについては「ハイブリッドなAIとして、クラウドとエッジをシームレスに繋ぐというのがAI PCの基本的な構成」と概要を説明。ここでは大規模なAIはクラウド、小規模なLLMの推論はローカルで処理するのが効率的とし、ユーザーは個人のデータをクラウドに出すことなく、安全にAIの恩恵が得られると話した。

また、AI向けクライアント製品に関しては、第3四半期出荷予定の「Lunar Lake」、第4四半期出荷予定の「Arrow Lake」を紹介。このうち薄型ノートPC向けとなるLunar LakeについてはNPU性能について言及。NPU単体でMicrosoft Copilotの動作要件となる40TOPSを上回る48TOPSを実現し、CPUとGPUの処理を合わせるとプロセッサ全体で120TOPSのAI処理性能を備える点をアピールした。

AI PCで"尖った"AIが登場する可能性。アイデアソンも実施

セッションの後半ではベンチャーキャピタル3社からゲストが登壇し、それぞれの立場からAI PCへの期待を述べた。登壇者はサイバーエージェント・キャピタル株式会社執行役員の速水陸生氏、株式会社ディープコア シニア・ディレクターの三宅俊毅氏、スクラムベンチャーズ合同会社パートナーのマイケル松村氏。

「ソフトウェアやアプリケーションを作るスタートアップにとって非常に良い機会が訪れたというのが率直な感想です。これまではビッグテックの大規模モデルを調整して、そこにUIをかぶせてアプリケーションを作る、ということが行なわれてきましたが、それでは尖ったものが作りにくいということがありました。

しかしAI PCの登場によって、デベロッパーが自身の力を自由に発揮できるフィールドができたように感じています。今後はいろいろなスタートアップのさまざまなチャレンジが見られると思うので、今からわくわくしています」(三宅氏)。

「AI処理をすべてクラウドに依存することには無理が出てきていることを感じています。PC環境でAIを活用する流れの中で、新たな技術が世に出て、結果としてどのようなソフトウェアが出てくるのか、どのようなユースケースが生まれるのか。僕個人としても楽しみにしています」(速水氏)。

なおインテルは本イベントに先がけて、AI PC向けアプリケーションのアイデアを競う「AI PC Future Ideathon」を5月に開催している。松村氏のコメントはAI PCそのものというよりは、アイデアソンの内容を踏まえたものとなった。

「今回のアイデアソンでポテンシャルを感じたのは次の3点。『分散型再生可能エネルギー』、『次世代モビリティ』、『研究開発』です。1つ目については、すでに従来の集中型システムから、分散型のシステムへ移行が始まっている中で、小規模かつ分散しているエネルギーのアセットからさまざまなデータが出ている点に注目しています。

2つ目は、ハードウェアに特化していた従来型のモビリティから、ソフトウェアの大切さが見直され、コネクテッドカーや自動運転などさまざまな領域で新しいデータが生まれている状況が気になっています。

3つ目は、データ処理にかかわる新しいマテリアルの登場に対する期待です。それは例えば、高温超伝導や新しい触媒やバッテリ材料などといったものです」(松村氏)

AI企業が活動する環境が整ってきている

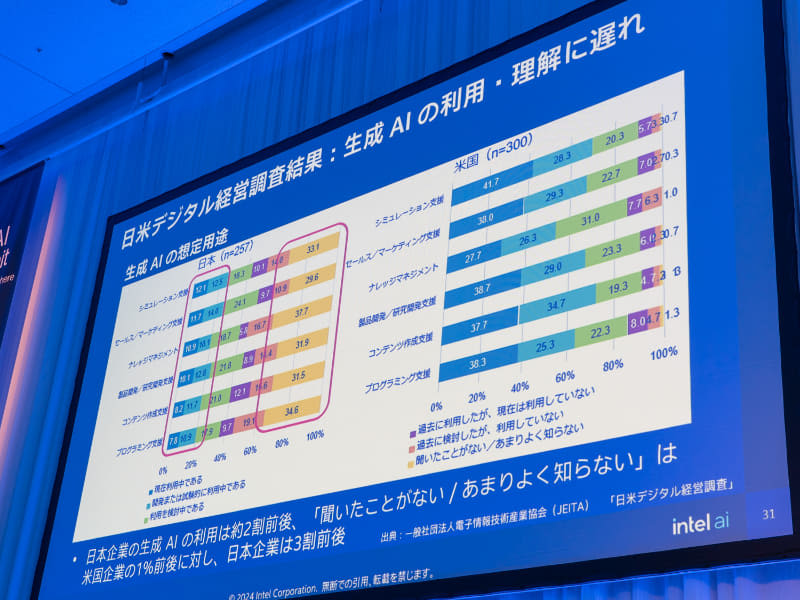

続いて鈴木氏は、企業における生成AIの利用/理解に関する日米間の差異に関する調査結果を提示し、日本側の課題について話した。調査では、米国に比べて日本企業は生成AIの利用が少ない傾向にあるとされる。ただ鈴木氏によると、直近でこの状況は急激に変化しているという。

「この1年で企業経営者のマインドセットは大きく変わってきていて、AIについては、プライバシーやセキュリティの問題は完全に排除できないけれども、とにかく導入してみよう、という動きが見えるようになってきました。私が今日このステージで申し上げたいのは、日本にはまだまだ"機会"があるということです。例えばOpenAIやsakana.aiなどの有力なスタートアップが日本に進出してオフィスを構えています。これは良い兆候だと思います」(鈴木氏)。

AIスタートアップが日本に進出する理由の一例としては著作権法の改正や円安を挙げ、AIスタートアップとして活動がしやすい地域として日本が選ばれていることを説明した。

また日本のAIスタートアップが増えていることもトピックとして挙げている。特に大学発のAIスタートアップが増えており、ここでも政府がAI企業に対して支援を行なっている点、AI企業が活動する環境が整ってきている点を高く評価している。

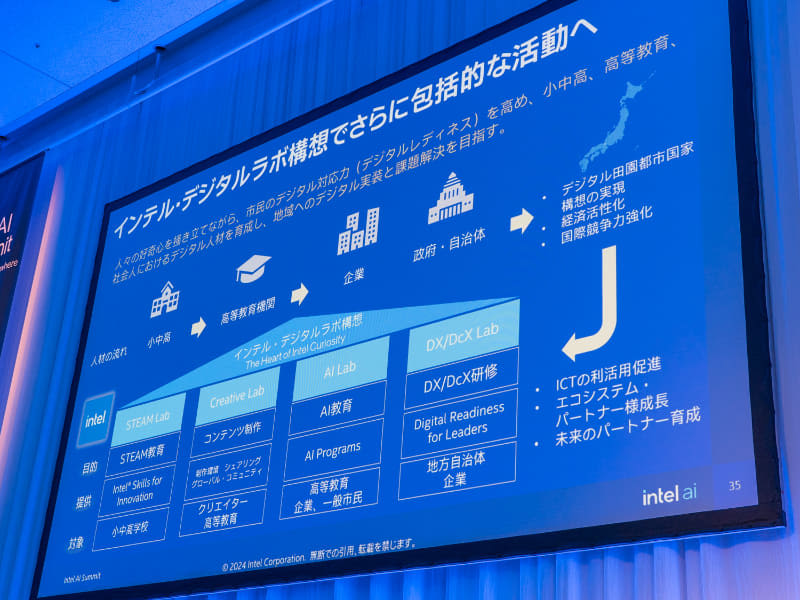

最後に、インテルが取り組んでいる人材育成事業について言及。インテルが学校や企業、政府/自治体などに提供しているSTEAM教育やAI教育、DX研修といったプログラムについて話した。