by 西田 宗千佳

アップルは年次開発者会議「WWDC 2024」で、新しい施策を多数発表した。その軸となるのは、AI戦略である「Apple Intelligence」だ。

これまでは地味な展開であった生成AIに関する取り組みを明確にし、iPhone・iPad・Macという主要製品に組み込んでいく。

筆者も現地で取材し、複数の記事を掲載しているが、今回はそれがどう動作していて、どんな変化をもたらそうとしているのかを、他社の動向と比較しながら語っていきたい。

デバイス内の「個人の行動」を使ってプライベートなAIを実現

アップルは自社のAI技術に「Apple Intelligence」と名前をつけた。

略称が「AI」とはなかなか洒落ているが、実のところ、1種類のAIで実現されている技術ではない。複数のAIモデルを組み合わせたもので、機能も多岐に渡る。ただし、公開は今年の秋に英語からスタートし、日本語を含む他の言語は来年(2025年)以降となる。

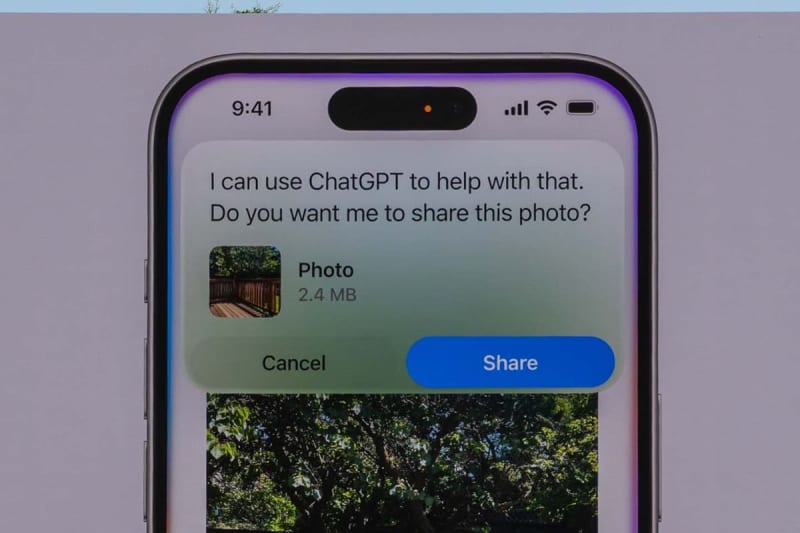

ChatGPTへの連携機能が搭載されたことが注目されているが、実のところ、アップルはこの部分をさほど重視していない。

テキストや画像からネット検索ができるようになっているが、それと同じように「検索としての生成AI」が使えるようにしている……と言っていいだろう。

現在もアップルは自前の検索エンジンを持たず、別の検索エンジンへ質問を投げる形を採っている。同様に、大規模な生成AIに質問を投げたい場合、連携機能を介してChatGPTへと受け渡す機能が搭載された……というイメージだ。今後GoogleのGeminiなどとの連携も進められていくため、契約はOpenAIとのエクスクルーシブなものではない。

アップルとしては、そういう検索よりも「デバイスの中で完結するパーソナルな用途」を重視しており、その実現こそが、アップル製品の魅力を拡大するために重要なこと……と考えているのである。

どんなものかと言えば、「機器の中の個人的な情報を活用するAI」というところだろうか。

ChatGPTにしろGeminiにしろ、クラウド上で使うチャットベースの生成AIは、「巨大な言語モデルの中に蓄積された情報」に問いかける形で使う。

利用者が共有する巨大なモデルを使うわけで、その回答も「あなたに特化したもの」にはなりづらい。質問内容を覚えておいたり、事前に応答の方向性を定めておいたりもできるが、利用者のプライベートな事柄までは知らない。

AIが人間のアシスタントになる、と規定するなら、自分のことを知っておいてくれた方がいい。だが、「多数で共有するAI」にプライバシーを蓄積していくのは課題も多い。

そこで出てきたのが、処理をデバイスの中で完結させる「オンデバイスAI」。マイクロソフトにしろGoogleにしろ、個人向けのデバイスではオンデバイスAIを動作させ、その中だけで処理する流れにはある。

Apple Intelligenceも、アップルが独自開発したオンデバイスAIモデルを使う、という意味では似ている。

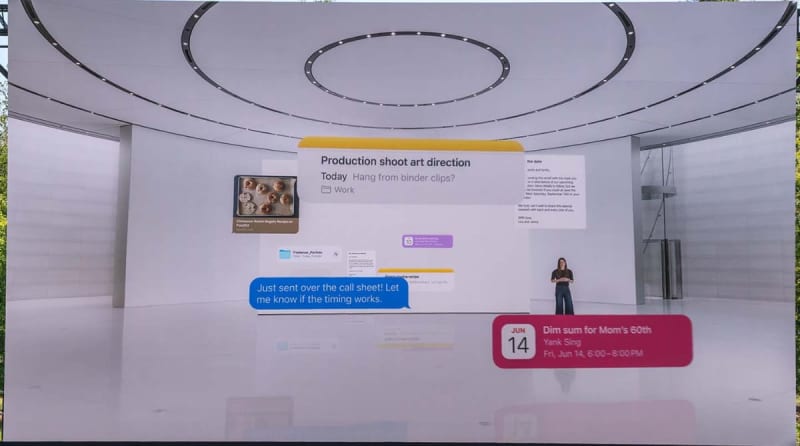

ただApple Intelligenceは、アプリの利用状況やメッセージ履歴、写真の中になにが写っているのかなど、「デバイスの中での個人の行動」を分析して利用するところが違う。

他社は現状、そこまで徹底しているわけではない。Googleが通話をリアルタイムに解析して特殊詐欺を警告したり、マイクロソフトが「Recall(回顧)」機能でPC上で見たものを思い出しやすくしたり、といったことにオンデバイスAIを使っているが、アプリやメッセージを横断しての活用を推進しているわけではない。

徹底したプライバシー対策のためにサーバーも専用開発

アップルが「個人の情報を扱うAI」をアピールできるのは、以前よりプライバシー重視の姿勢を貫いていたからでもある。

他社ももちろん、プライバシー情報を切り売りしていたわけではない。よく「ビッグテックのサービスを使っているなら、秘密はすべて筒抜け」という人もいるが、さすがに穿った見方だ。少なくとも利用許諾上は、野放図に情報を見られることはない。

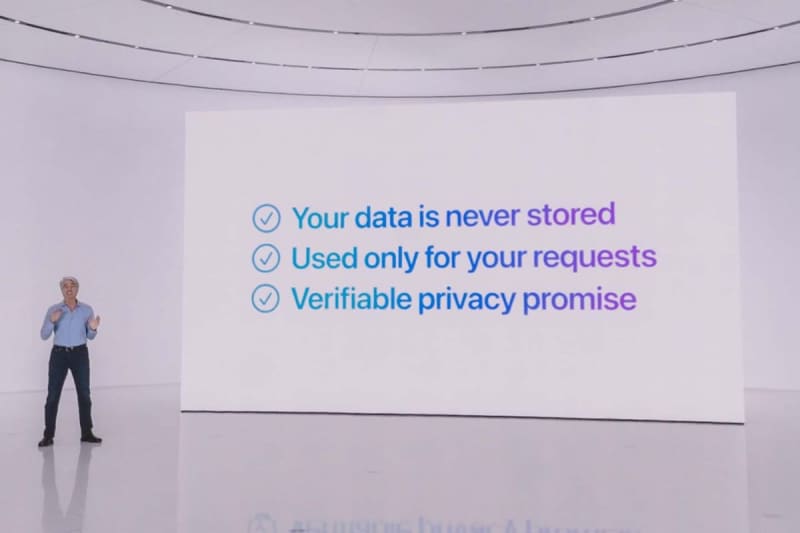

ただ、今回アップルが打ち出した技術は、他社とは徹底ぶりが違う。

Apple Intelligenceには「Private Cloud Compute」という技術が導入されている。

名前の通り「クラウド」を使うのだが、一般的なクラウドAIとも、ChatGPT連携とも異なる性質のものだ。

オンデバイスAIの欠点は「AIの能力に制限がある」ことだ。クラウドと手元の機器では処理能力に大きな差がある。消費電力やコストを考えればそれは致し方ないことだ。特にスマートフォンでは、PCのように高性能なGPUや大量のメモリーを用意するのも難しい。パーソナルなアシスタントとしてのAIはスマホでこそ生きるものだ。

そこでアップルは、オンデバイスAIを基礎に置きつつも、処理能力が足りない場合にクラウドの能力を呼び出す機能を搭載した。これが「Private Cloud Compute」だ。

Private Cloud Computeで使うのはアップルが用意する専用データセンター。その中にあるのは、アップルが独自に開発した専用のサーバー群だ。

処理能力が足りない場合、Apple Intelligence対応の機器はPrivate Cloud Computeを呼び出し、処理用に匿名化した情報を送り、クラウド側で処理をする。その後データは消去され、クラウドには残らない。

「そんなこと言っても、プライバシーに配慮してクラウドを使うという文言は他社と同じではないか」

そう思う方もいると思う。

だが、Private Cloud Computeはクラウド側の構造から大きく違う。

サーバーはいわゆるAppleシリコンをベースに作られたもので、OSはiOSとmacOSを基盤としたサブセットで、AIの推論に特化している。その上で、個人が購入する各デバイスよりも高い推論能力があると推測できる。

情報はデバイスとサーバーの間でエンド・トゥ・エンド暗号化が行なわれ、経路で盗み見られる可能性も低い。

一般のサーバーと大きく異なるのは「情報を蓄積するためのストレージがない」こと。処理した情報を蓄積しようがないため、処理が終わったら捨てるしかない。

また、リモートアクセス用のターミナルを含めた「汎用的な管理用アクセス手段」もない。接続できるのは、アップルが認証した手段を備えた機器だけだ。だから、汎用的な攻撃手段での不正アクセスされる可能性はより低い。サーバー自体が汎用でなく、どこにどう接続されたかを出荷レベルで厳密に管理しているという。

このようなアップル製品に閉じた作りのサーバーで処理するからこそ、「クラウドを使っているが、オンデバイスAIと同じレベルのプライバシーを保てる」ようになるわけだ。

また、どういう仕組みで動いているかを検証するためのソフトウエアは公開されるため、その妥当性をセキュリティ研究者が検証し、使用許諾と齟齬がないよう検証する透明性も担保しているという。

結果として、処理能力に限界があるオンデバイスAIをメインとしつつも、軽い処理ばかりに特化せず、「デバイスの中のプライベートなパートナーとしてAIを活用する」を目指して使えるようになっているわけだ。

ただ、どのくらい賢いかはまだよくわからない。発表はあったが、プレスはおろかデベロッパーですらさわれていないのが現状だ。だが、より個人的なデータとAIが連携し、十分な演算力も使って回答されるのだとしたら、「いままでより賢いパートナーAIになる」と期待したくなる。

おそらく初期にはPrivate Cloud Computeへの依存度も高いだろうが、デバイスの性能とAIが進化するに従って、クラウドへの依存度は減っていくと思われる。

ちなみに、アップルのデータセンターは全て再生可能エネルギーで運営されているが、Private Cloud Computeもその方針は変わらないという。

また、前述のようにPrivate Cloud Computeは推論の仕組みなので、AIの学習自体は別の仕組みで行う。データが保存されないわけだから、AIの学習に個人の情報が使われることもない。

「音声アシスタント」の競争が再び始まる

Apple Intelligenceには多数の機能があるが、もっとも大きな影響が出そうなのが「Siriの高度化」だ。

これまでのSiriは決まった命令をしてもらう、というイメージに近かった。その先で求められる人間的な反応を実現するのが難しく、「音声アシスタント」という言葉に期待するような動作をしていたとは言い難い。

これはAmazonのAlexaにしろGoogleアシスタントにしろ同様だろう。

そこで、OpenAIが「GPT-4o」で滑らかな音声対話を行ったので、ある種お株を奪われたような印象を受けた人も多いはずだ。

とはいえ、前述のように、OpenAIが目指すものと、アップルやGoogleが目指す音声アシスタントはイコールではない。賢いAIができても、結局のところ「自分の事情をわかっていてくれる」ものでないと、毎回事情を伝えないといけないからだ。

そこでどういうアプローチを採るかが、OSというプラットフォームを持つ企業とそうでない企業の差になるだろう。

OpenAIのアプローチが他社より不利、とは思わないが、スマホ内の個人データにアクセスし、蓄積を活用するプラットフォーマーとは、自ずと使われ方が違ってくるのではないかと予想している。

そんな中Amazonは、昨年9月に「Alexaへの生成AI導入」を発表している。まだテストは始まっておらず、展開は遅れているように見える。

一部で「Alexa有料化」と噂されているのは、この「生成AIによる応答」の部分だろう。

こちらも実際にどういう使い勝手になるのかは、まだ今ひとつわからない。発表から時間が経ちすぎて、注目度も薄れているように感じる。

今秋にアップルが英語版でApple Intelligenceのテストを開始すると、他社との競争も激しくなっていくだろう。

生成AIのデバイス導入は音声アシスタントだけに関連するものではないが、各社の方向性を示すものとして、まずは「音声アシスタントの進化」が注目されるのは間違いない。