by 北川 研斗

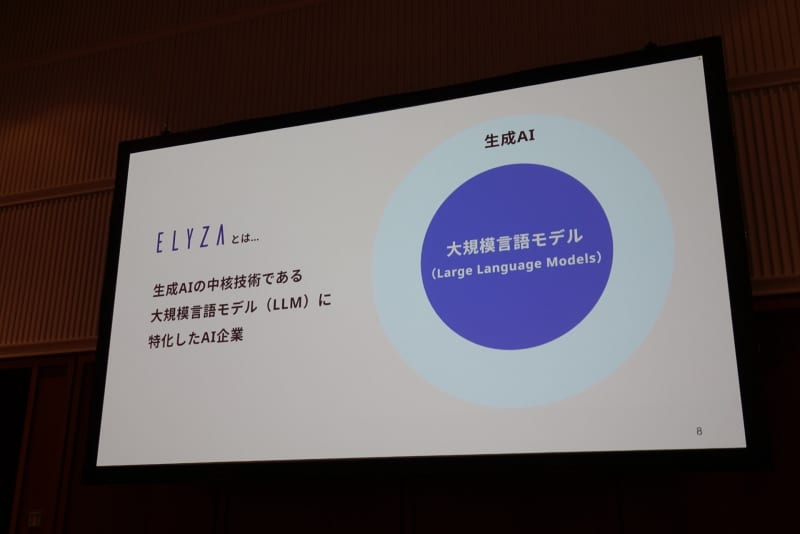

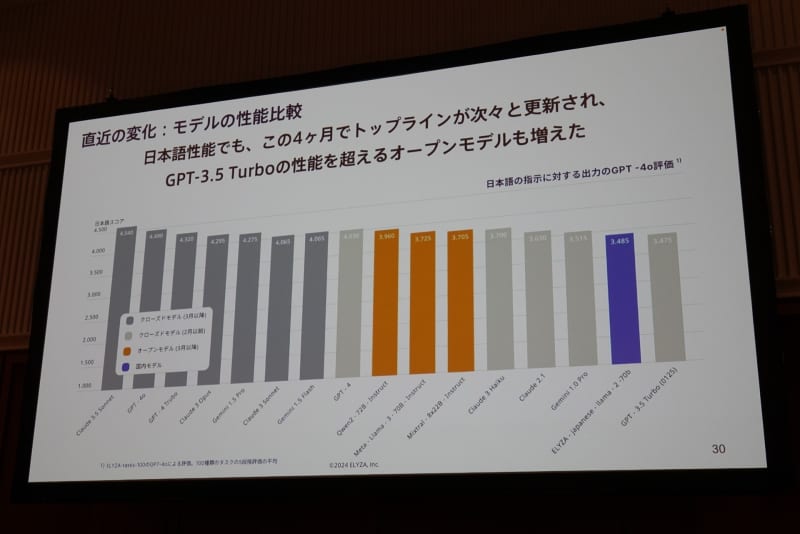

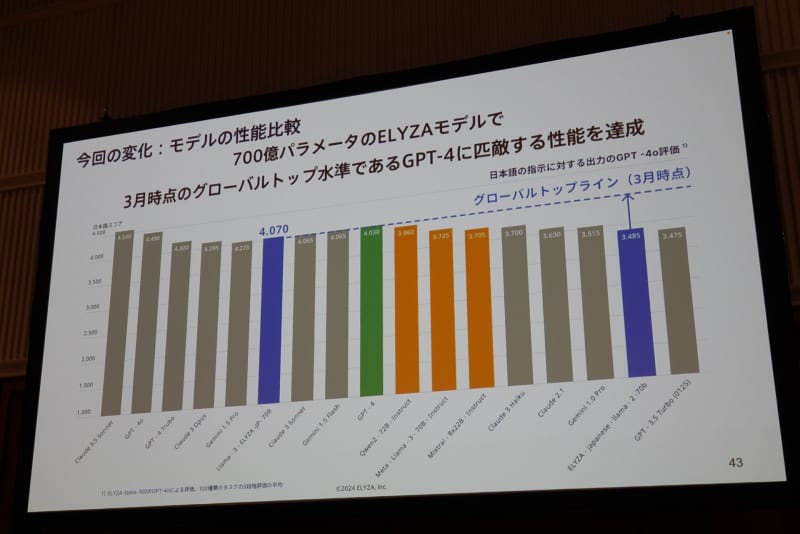

KDDI傘下でAIを手がけるELYZAは、新たな日本語LLM(大規模言語モデル)2種を公開した。700億パラメーターのモデルは「GPT-4」を上回る性能を持つとしており、80億パラメーターのモデルは今後、商用利用できるかたちで一般公開される。

700億/80億パラメーターの2種を開発

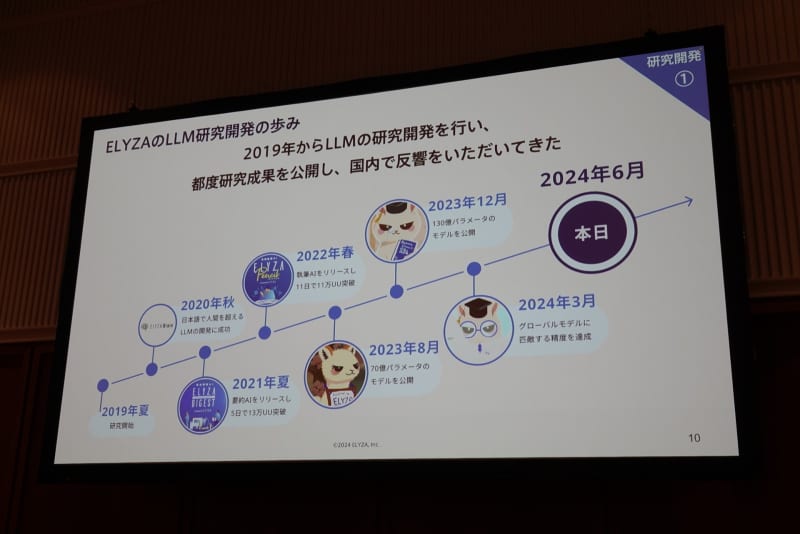

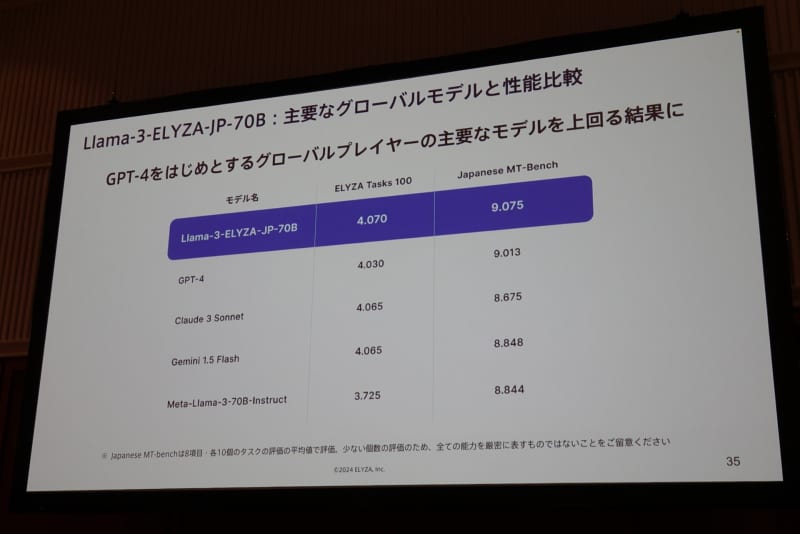

ELYZAが開発に成功したのは、米Metaのオープンモデル「Llama 3」をベースにしたもので80億パラメーターのモデル「Llama-3-ELYZA-JP-8B」と700億パラメーターのモデル「Llama-3-ELYZA-JP-70B」の2つ。700億パラメーターのモデルは、米OpenAIの「GPT-4」を上回る性能を達成したという。

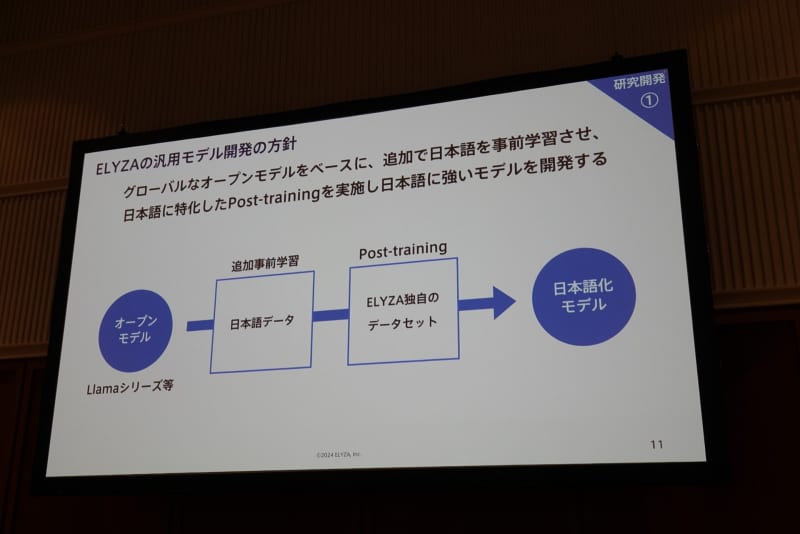

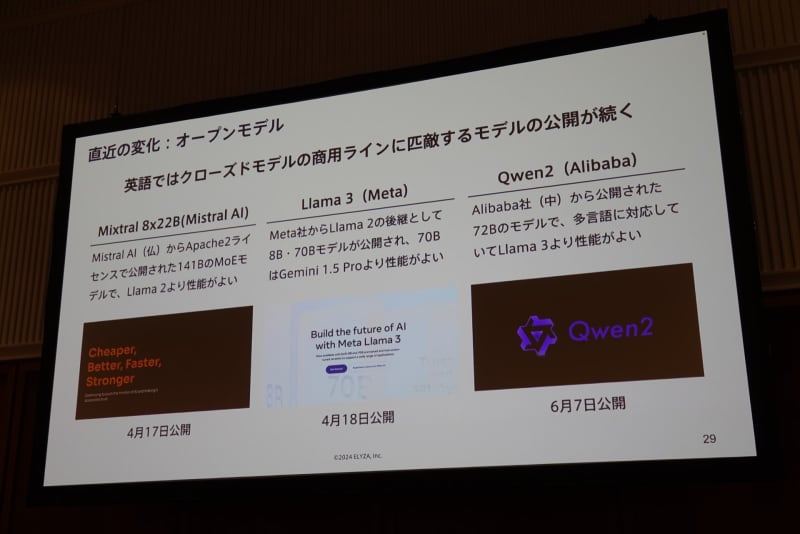

ELYZAが新開発した2つのAIモデルのベースになっているのは、Metaが開発しオープンモデルとして公開されている「Llama 3」で、これに独自の追加事前学習やPost-trainingと呼ばれる作業を行うことで開発した。

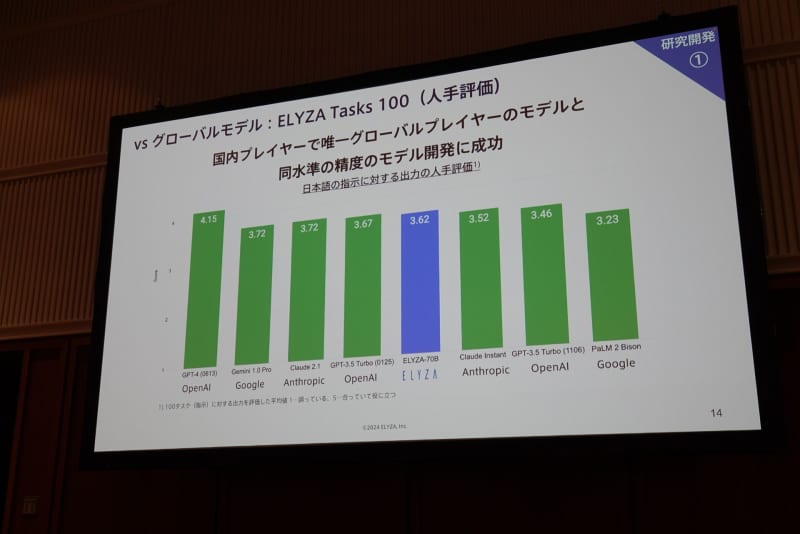

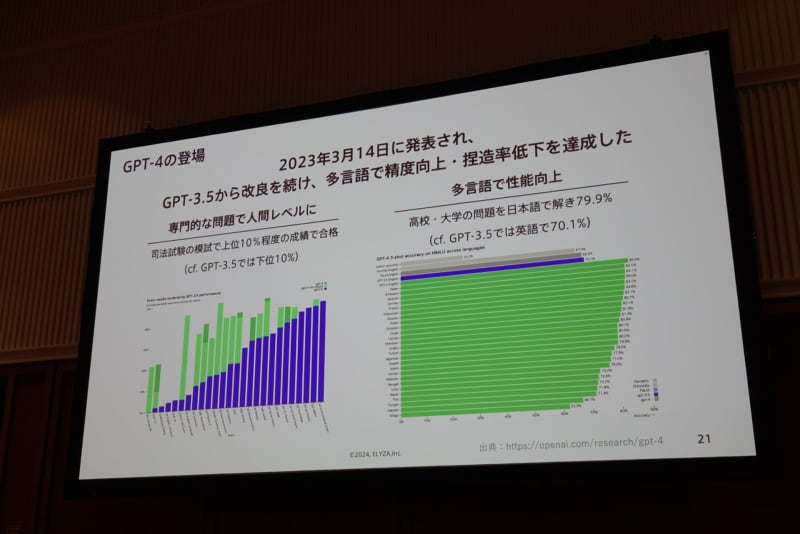

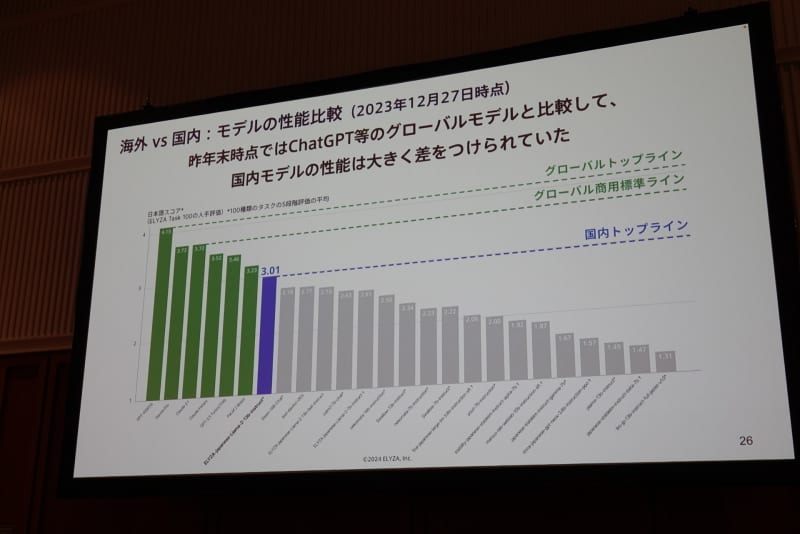

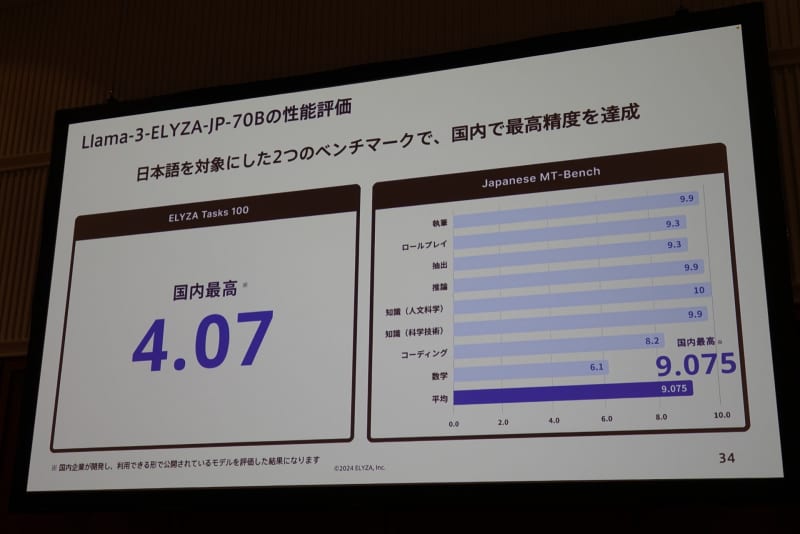

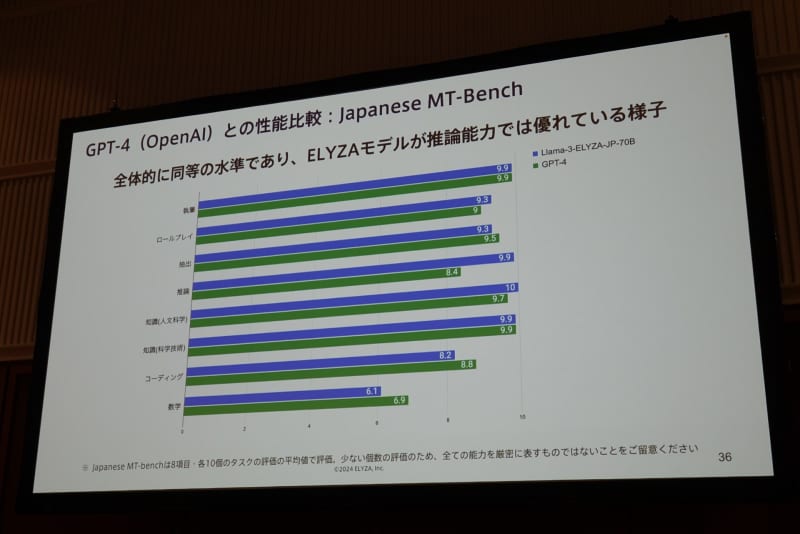

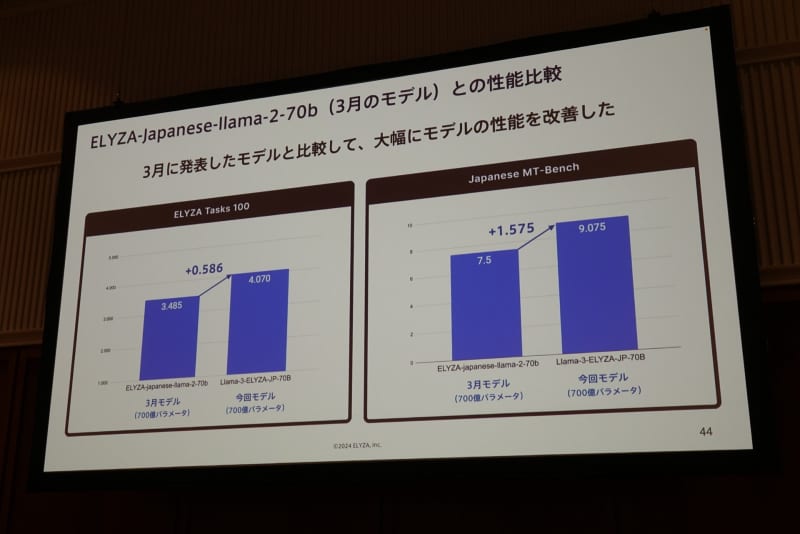

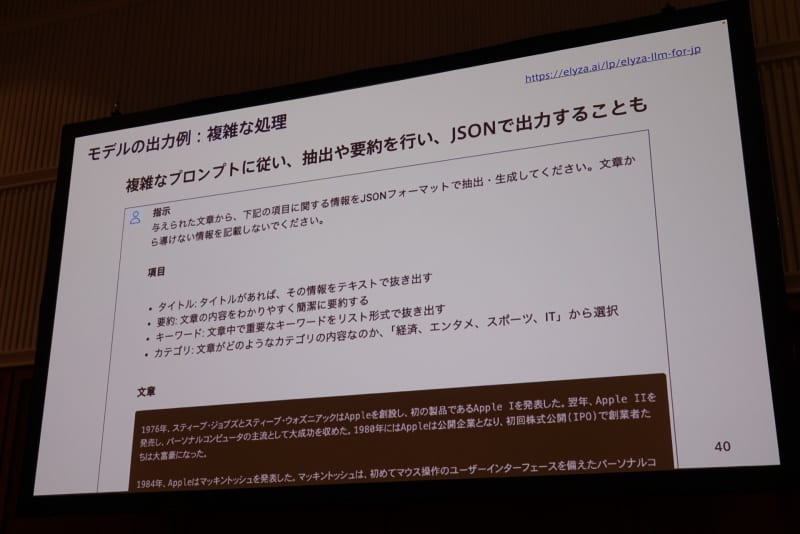

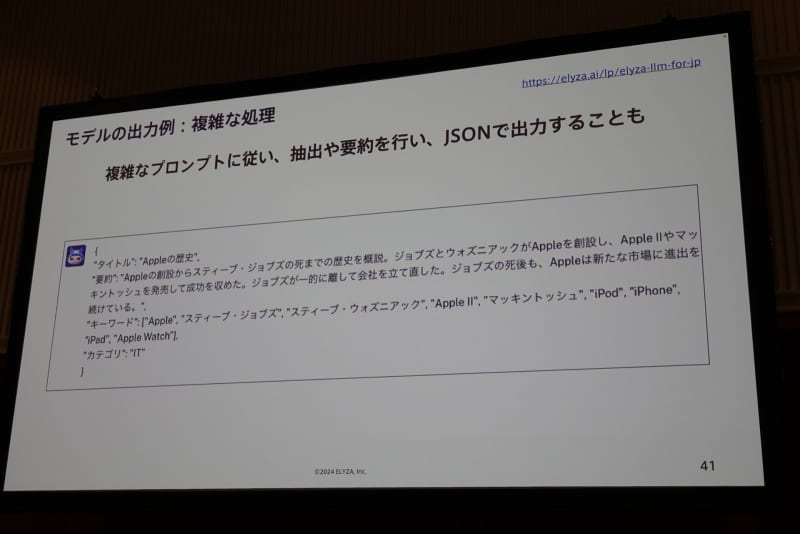

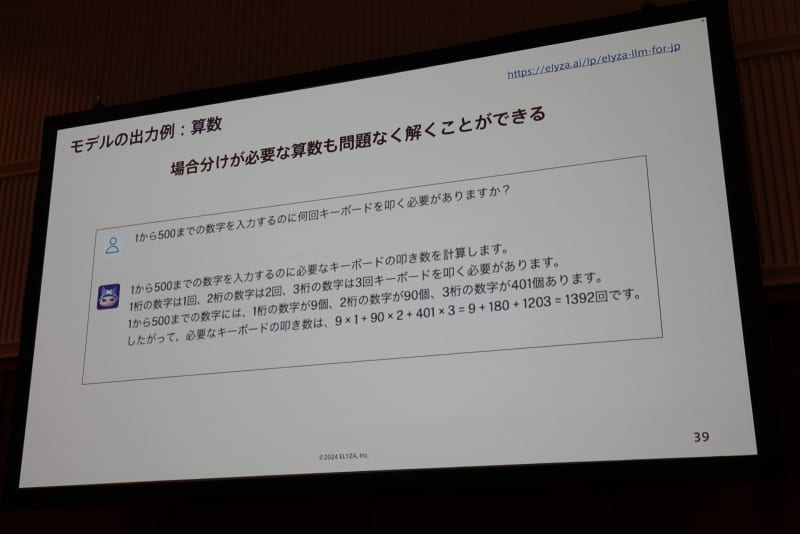

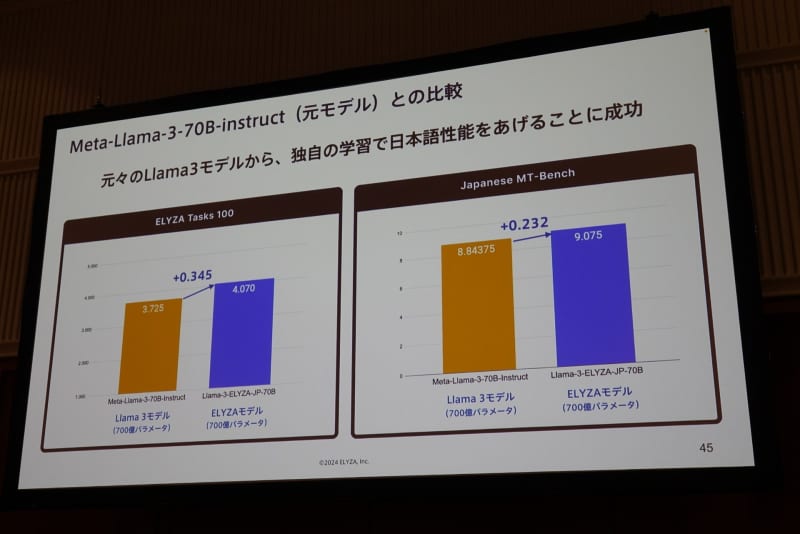

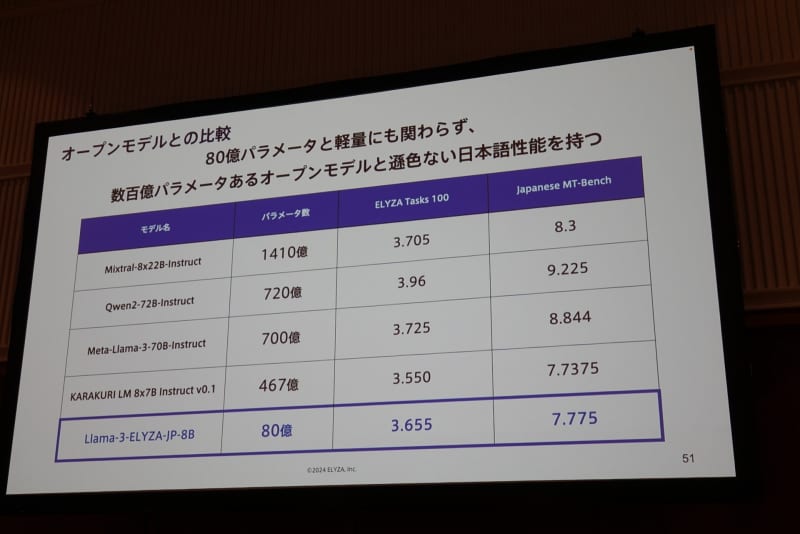

700億パラメーターのモデルは、日本語のベンチマーク「ELYZA Tasks 100」と「Japanese MT-Bench」でともに国内最高精度を達成した。主要なグローバルプレイヤーが開発したLLMと比較しても性能が高く、いずれのベンチマークでもOpenAIの「GPT-4」が記録したスコアを上回った。数学はまだ発展の余地を残しているものの、全体で比較するとほとんど同等レベルの性能を発揮しており、推論能力はELYZA開発のモデルが優れているという。

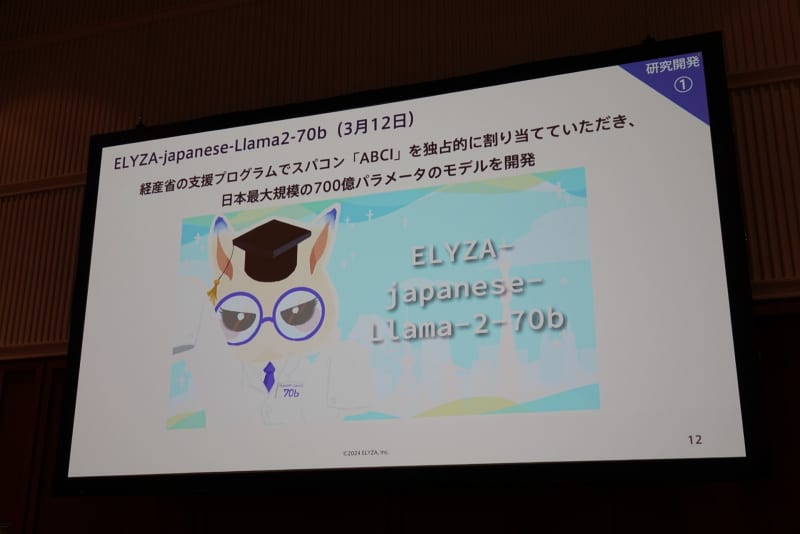

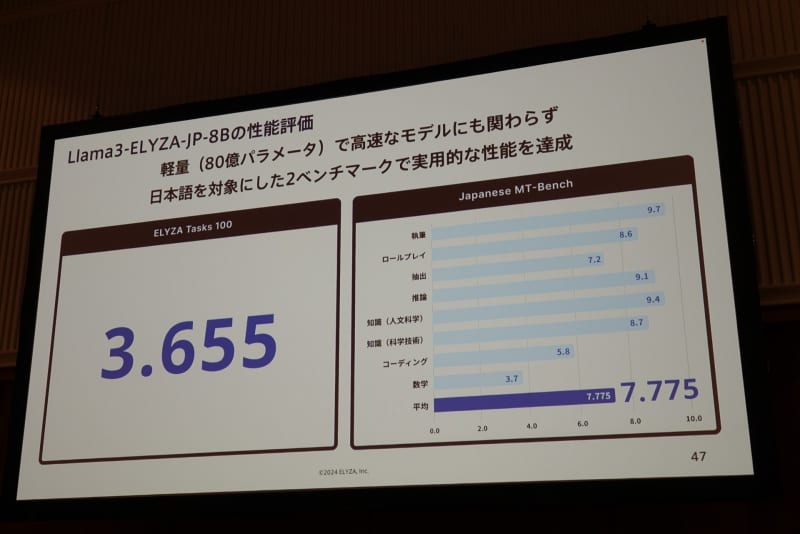

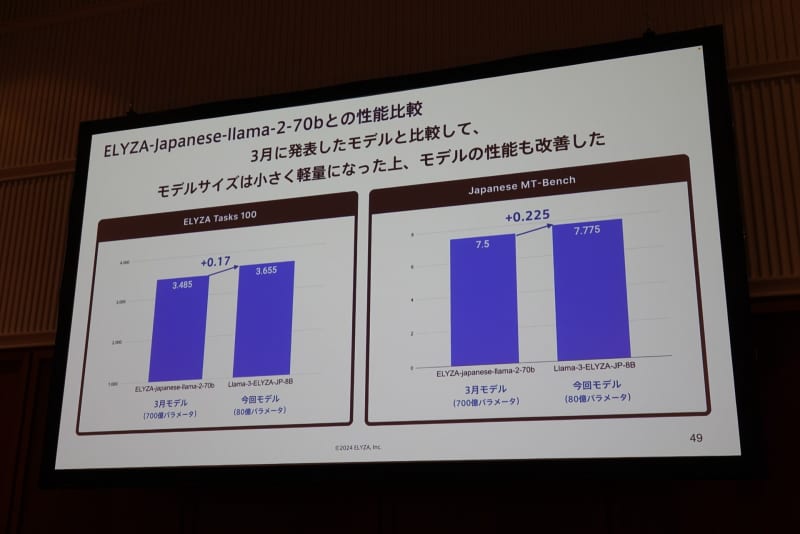

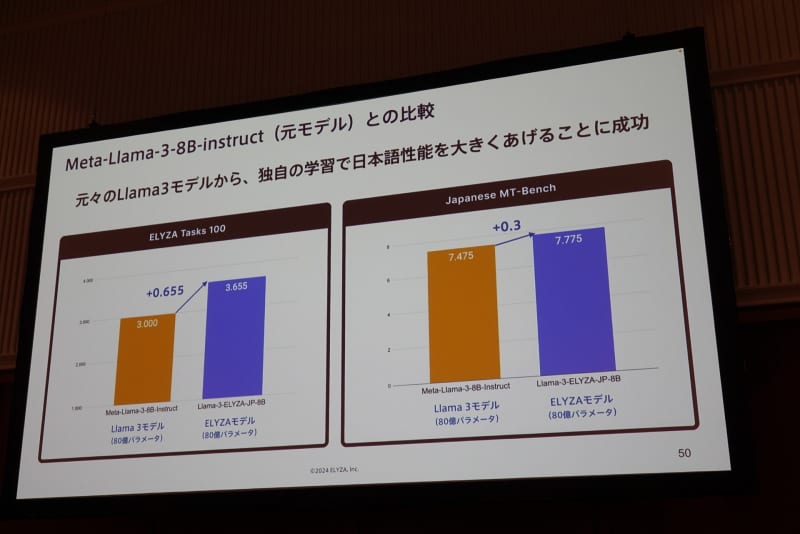

あわせてより軽量な80億パラメーターのモデルも公開。同社は3月にも「Llama 2」ベースで700億パラメーターの日本語LLMを発表していたが、それと比較しても性能は向上した。

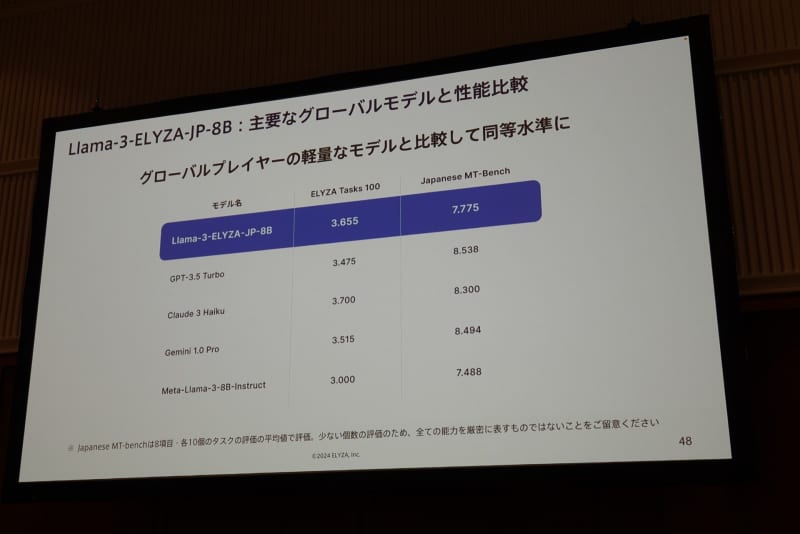

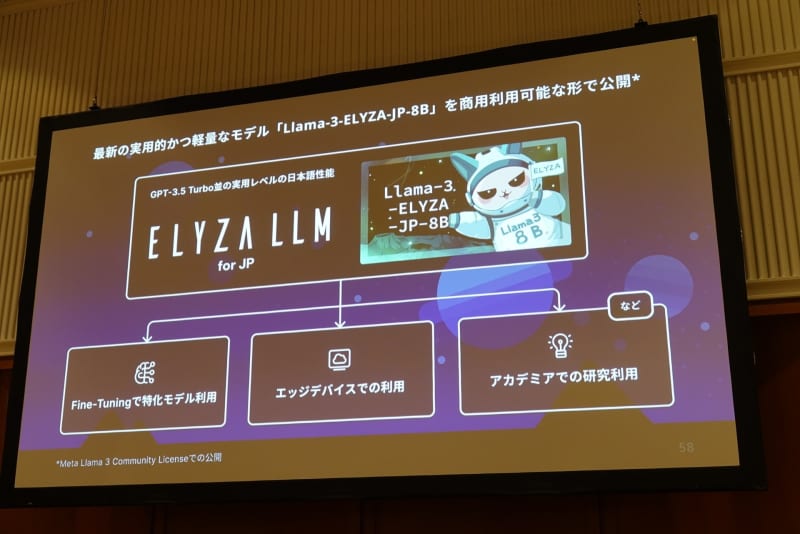

「GPT-3.5 Turbo」や「Claude 3 Haiku」「Gemini 1.0 Pro」などに匹敵し、パラメーター数で1桁上回る、グローバルモデルと比較しても日本語性能は見劣りせず軽量にもかかわらず高性能さを特徴とする。

社会実装にも意気込み

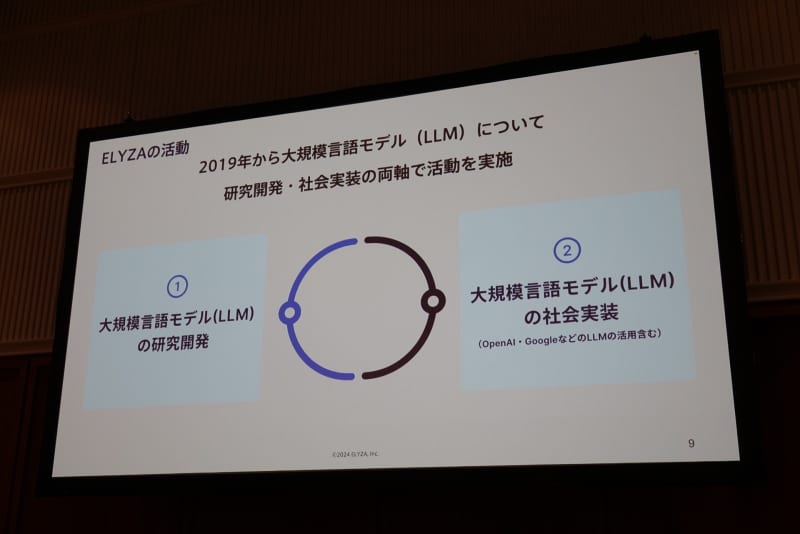

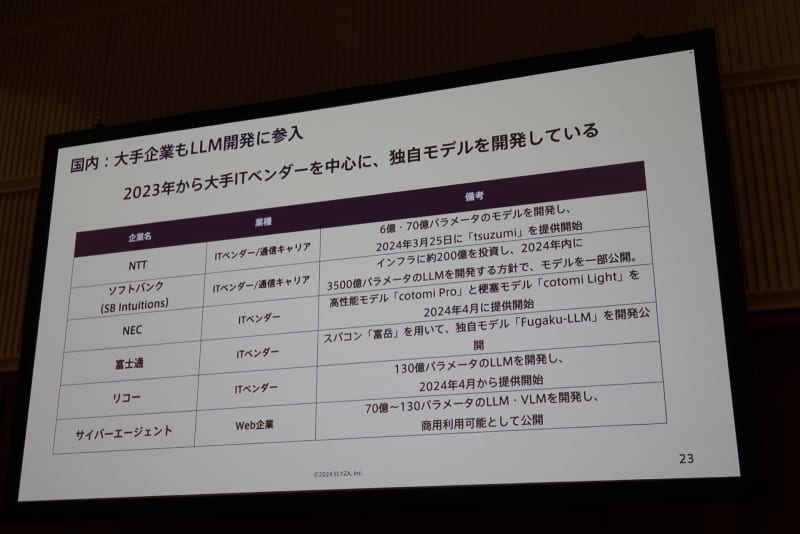

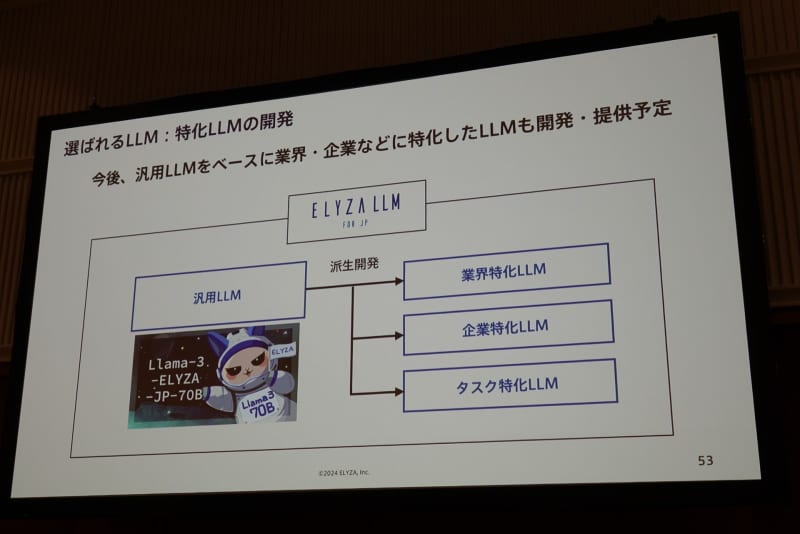

ELYZA 代表取締役の曽根岡侑也氏は、LLMの技術開発と並行して実社会におけるLLMの活用も重要視していると語る。汎用LLMを軸に、業界や特定の企業・タスクに特化したLLMを開発し、提供していきたいと展望を描く。

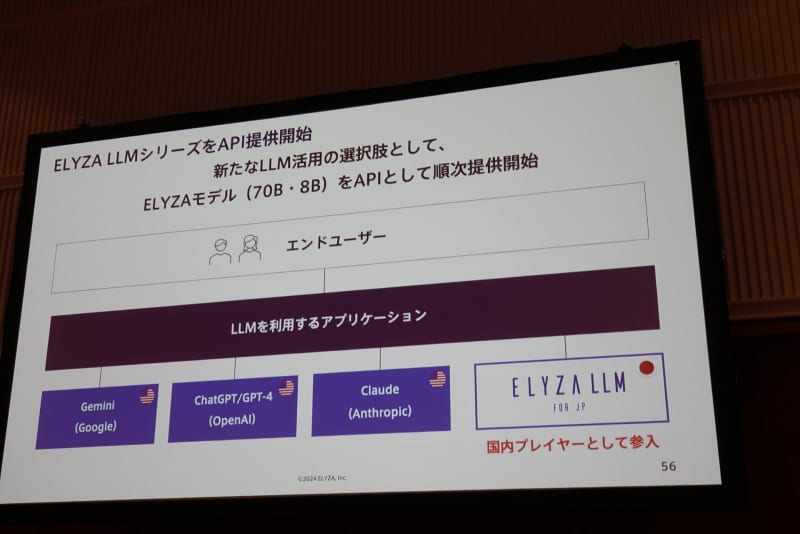

すでに第1弾として、日本の法律や行政関連の知識に最適化されたLLMを開発中で、第2弾、第3弾もすでに準備が進んでいるという。あわせてAPI「ELYZA LLM」で、これまでグローバルモデルで独占されていた生成AIのAPIに国産の選択肢を提供する。

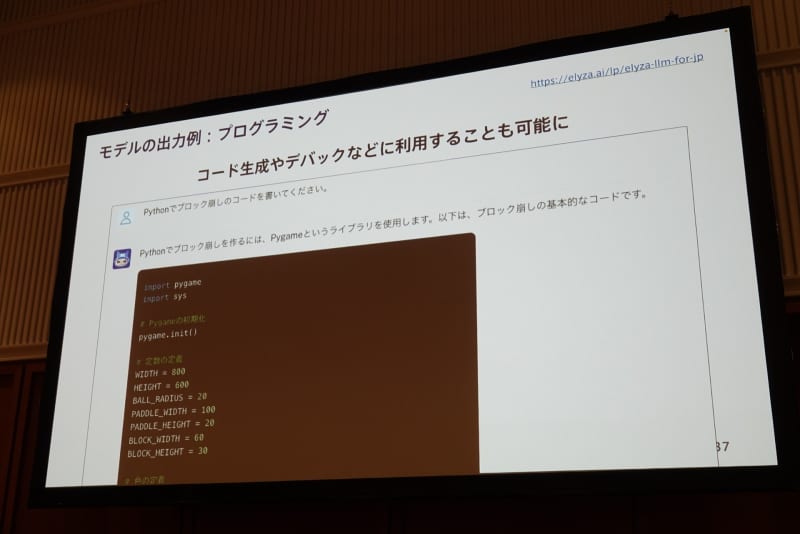

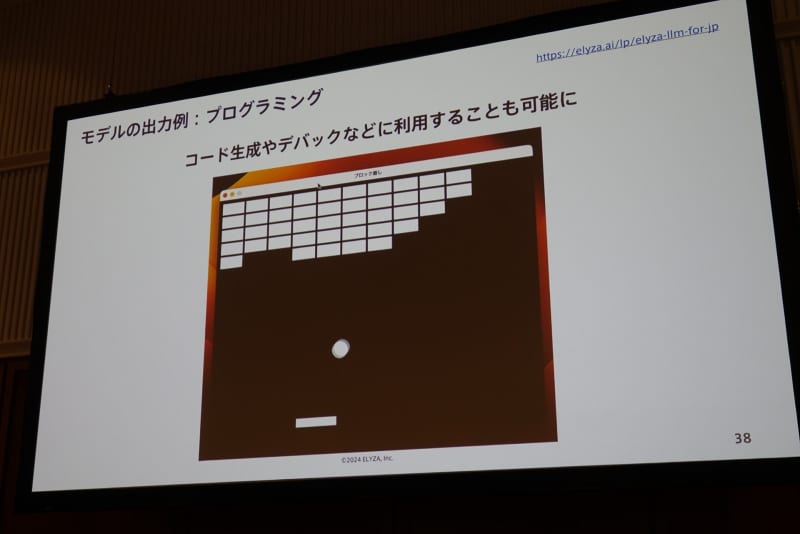

今回発表された80億パラメーターのモデルは商用利用できるかたちで公開される。活用の事例として曽根岡氏は、パソコンや自動車を含めたエッジデバイス、研究目的での利用などをあげて、AIの社会実装を支援していく旨を語った。