by 臼田勤哉

ELYZAは、大規模言語モデル「ELYZA LLM for JP」シリーズの最新モデルとして、Metaの「Llama 3」をベースとした700億パラメータの「Llama-3-ELYZA-JP-70B」と80億パラメータの「Llama-3-ELYZA-JP-8B」を開発し、性能を公開した。70Bモデルは、日本語の生成能力において「GPT-4」超えを達成したという。

70Bモデルは、チャット形式のデモも用意し、高性能な国内製モデルとして、企業向けに提供する。MetaのLlama-3-70Bをベースに追加の学習(日本語追加事前学習・指示学習)を実施して開発。日本語の性能を測定する2つのベンチマークにおいて、国内モデルの中では最高性能の水準となり、「GPT-4」や「Claude 3 Sonnet」、「Gemini 1.5 Flash」と同等もしくは上回る性能を達成したという。

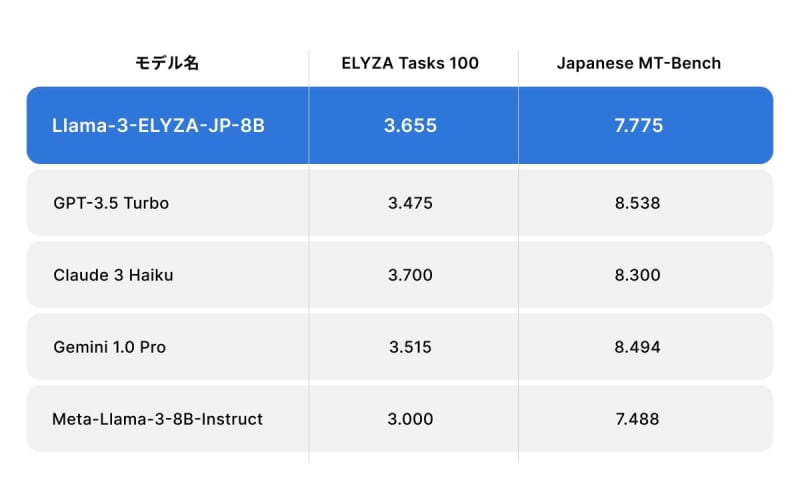

8Bモデルは、MetaのLlama-3-8Bをベースに事後学習(日本語追加事前学習・指示学習)を実施。「GPT-3.5 turboを上回る性能」で、オープンなモデルのなかでは最高水準の性能をとしている。研究だけでなく商業目的での利用が可能な形で一般公開し、LLAMA 3 COMMUNITY LICENSEに準拠する。

ELYZAでは今後、Llamaシリーズだけでなく、海外のオープンモデルの日本語化や、その方法論の確立、独自LLMの開発に継続して投資をしていく。